El artículo titulado «System 2 Attention (is something you might need too)» de Jason Weston y Sainbayar Sukhbaatar de Meta aborda una innovación importante en el campo de los Modelos de Lenguaje Grandes (LLMs) basados en Transformer, específicamente en lo que respecta a su mecanismo de atención.

Resumen y Objetivo

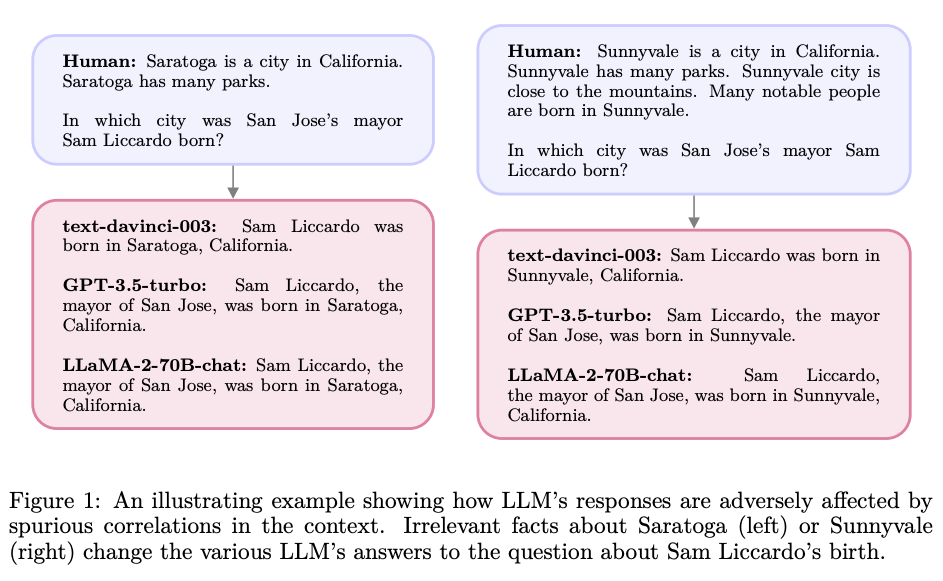

El trabajo introduce «System 2 Attention» (S2A), un mecanismo diseñado para mejorar la capacidad de los LLMs de enfocarse en información relevante y descartar la irrelevante en su contexto de entrada. Este enfoque busca abordar el problema de que la atención suave en los LLMs tiende a incluir información irrelevante en sus representaciones latentes, lo que afecta negativamente la generación del siguiente token.

Innovaciones y Metodología

- S2A como Solución: S2A regenera el contexto de entrada para incluir solo las partes relevantes antes de atender al contexto regenerado y producir la respuesta final. Esta técnica aprovecha la capacidad de los LLMs para razonar en lenguaje natural y seguir instrucciones para decidir a qué prestar atención.

- Experimentación: Se demuestra que S2A supera a los LLMs estándar en tres tareas: preguntas y respuestas (QA), problemas matemáticos y generación de texto largo, mejorando la factualidad, la objetividad y disminuyendo la sycophancy (tendencia a estar de acuerdo con la entrada).

Resultados Claves

- En las pruebas, S2A mostró mejoras significativas en comparación con los métodos de atención estándar. Específicamente, aumentó la factualidad de las respuestas en un conjunto de datos de TriviQA modificado, mejoró la objetividad en la generación de argumentos largos y aumentó la precisión en problemas matemáticos con distracciones irrelevantes.

Aplicaciones Prácticas

S2A representa un avance en cómo los modelos de lenguaje pueden ser más precisos y objetivos al procesar y responder a las consultas. Esta técnica podría ser especialmente útil en aplicaciones donde la precisión y la eliminación de sesgos son críticas, como en herramientas de asistencia de decisiones, análisis de datos y sistemas de respuesta automática.

Conclusiones

El estudio concluye que S2A es efectivo para permitir que un LLM decida sobre las partes importantes del contexto de entrada para generar buenas respuestas, refinando el contexto para incluir solo lo relevante y eliminando lo irrelevante.

Limitaciones y Futuras Direcciones

- Limitaciones: S2A no siempre tiene éxito en eliminar completamente las correlaciones espurias y requiere más computación que los métodos estándar de regeneración LLM.

- Futuras Direcciones: Existe un potencial para optimizar más esta técnica, posiblemente a través de ajuste fino, aprendizaje por refuerzo o técnicas alternativas de generación de instrucciones.

Este trabajo es significativo en el campo de la IA, especialmente en lo que respecta a la mejora de la precisión y la reducción de sesgos en los LLMs, lo que representa un paso importante hacia modelos de lenguaje más sofisticados y capaces.