La Inteligencia Emocional en IA

La intersección entre la IA y las emociones humanas es un terreno fértil para la investigación, abriendo caminos hacia máquinas que no solo comprenden datos, sino también el matiz de los sentimientos humanos. En un estudio reciente liderado por Cheng Li, del Instituto de Software de la Academia de Ciencias de China, y colaboradores de Microsoft, William & Mary, la Universidad Normal de Beijing y HKUST, se aborda esta cuestión con profundidad y rigor científico.

El estudio titulado «Large Language Models Understand and Can Be Enhanced by Emotional Stimuli» se centra en explorar la capacidad de los Modelos de Lenguaje de Gran Escala (LLMs) para procesar y responder a estímulos emocionales. La investigación parte de la premisa de que la inteligencia emocional es esencial en nuestras interacciones cotidianas y podría ser un componente vital en la evolución de la IA hacia formas más avanzadas de inteligencia general.

Los autores presentan una innovadora metodología denominada «EmotionPrompt«, con la que buscan demostrar que al incorporar estímulos emocionales en las solicitudes hechas a los LLMs, se puede mejorar notablemente su rendimiento en una amplia gama de tareas. Estos modelos, que incluyen desarrollos punteros como Flan-T5-Large, Vicuna, Llama 2, BLOOM, ChatGPT y GPT-4, se someten a una batería de pruebas diseñadas para desentrañar el grado en que la inteligencia emocional ya está presente y cómo puede ser potenciada.

La relevancia de este estudio radica en su potencial para transformar la forma en que las máquinas comprenden y se relacionan con los humanos, señalando un futuro en el que la inteligencia artificial podría no solo entender las palabras que decimos, sino también el tono emocional con el que las decimos, adaptándose y respondiendo de una manera que refleje un verdadero entendimiento de las emociones humanas.

Comprensión de la Inteligencia Emocional por LLMs

La inteligencia emocional, esa capacidad de percibir, asimilar, comprender y regular nuestras emociones y las de los demás, es una piedra angular de las interacciones humanas. En el ámbito de la inteligencia artificial, los Modelos de Lenguaje de Gran Escala (LLMs) han surgido como potentes herramientas capaces de procesar y generar lenguaje con un nivel de sofisticación cada vez más cercano al humano. Estos modelos han revolucionado tareas como la traducción automática, la generación de texto y la comprensión lectora, pero ¿pueden realmente entender y replicar la complejidad de las emociones humanas?

Los LLMs son sistemas de aprendizaje automático que han sido entrenados con grandes volúmenes de texto. A través de este entrenamiento, aprenden a predecir la siguiente palabra en una oración y, con ello, adquieren la capacidad de generar texto coherente y contextualmente relevante. Sin embargo, comprender y responder adecuadamente a los estímulos emocionales implica un nivel de sutileza que va más allá del simple procesamiento de información; requiere una sensibilidad que ha sido históricamente el dominio exclusivo de los seres humanos.

¿Que es un EmotionPrompt?

En este estudio, los investigadores introducen el concepto de «EmotionPrompt» como una herramienta para evaluar y mejorar la capacidad emocional de los LLMs. Un EmotionPrompt es un estímulo diseñado para evocar una respuesta emocional específica, que se incorpora en el prompt o comando original entregado al modelo. La hipótesis es que, al igual que en las interacciones humanas, la inclusión de un contexto emocional puede llevar a respuestas más ricas y matizadas por parte de los LLMs.

Para evaluar esta hipótesis, los autores diseñaron una serie de experimentos en los que compararon las respuestas de los LLMs a prompts estándar con sus respuestas a EmotionPrompts. Esto no solo proporciona una ventana hacia la comprensión actual de la inteligencia emocional por parte de los LLMs, sino que también ofrece una vía para mejorarla. La implicación es profunda: si los LLMs pueden ser entrenados para reconocer y responder a las emociones humanas con mayor precisión, podrían desarrollarse aplicaciones más empáticas y efectivas en campos como el servicio al cliente, la educación y la terapia.

Metodología

A través de un enfoque multifacético, se diseñaron 45 tareas distintas para evaluar la capacidad de respuesta de varios modelos frente a estímulos emocionales. Los modelos examinados incluyen algunos de los más avanzados en el campo, como Flan-T5-Large, Vicuna, Llama 2, BLOOM, ChatGPT y GPT-4, que han sido entrenados con extensas bases de datos de texto y representan la vanguardia en la generación de lenguaje natural.

Estas tareas se dividen en dos categorías principales: determinísticas y generativas. Las tareas determinísticas son aquellas en las que hay una respuesta correcta o deseada claramente definida, mientras que las tareas generativas requieren que el modelo produzca respuestas más abiertas y creativas. Esta distinción permite a los investigadores evaluar no sólo la precisión de los modelos en tareas concretas, sino también su habilidad para generar contenido nuevo y relevante en contextos menos estructurados.

Para los experimentos automáticos, se utilizaron métricas existentes para evaluar las respuestas de los modelos, proporcionando una evaluación objetiva de su rendimiento. Estas métricas varían según la naturaleza de la tarea, pero en general buscan medir la exactitud, la coherencia y, en el caso de las tareas generativas, la creatividad y la relevancia emocional de las respuestas.

Además, se llevó a cabo un estudio humano con 106 participantes para obtener una perspectiva más cualitativa de la efectividad de los EmotionPrompts. Los participantes evaluaron las respuestas de los modelos en tareas generativas, considerando aspectos como la veracidad, la responsabilidad y la empatía de las respuestas. Este enfoque híbrido de evaluación automática y juicio humano permite una comprensión más completa de cómo los LLMs manejan los estímulos emocionales y cuán efectivamente pueden ser mejorados a través de técnicas innovadoras como el EmotionPrompt.

Resultados de los Experimentos Automáticos

La evaluación de los Modelos de Lenguaje de Gran Escala (LLMs) a través de experimentos automáticos ha revelado hallazgos significativos acerca de la comprensión y la capacidad de mejora de la inteligencia emocional en estos sistemas. Los autores del estudio presentaron a los modelos una serie de tareas con y sin EmotionPrompts para medir el impacto de estos estímulos emocionales.

Los resultados fueron reveladores. En tareas de inducción de instrucciones, se observó una mejora del rendimiento relativo del 8.00% cuando se utilizaron EmotionPrompts. Esta mejora no solo refleja una mayor precisión en las tareas específicas, sino que también indica un entendimiento más matizado de las instrucciones en el contexto de las emociones implicadas. En el caso del BIG-Bench, que es un conjunto de tareas diseñado para probar los límites de los LLMs, se registró una impresionante mejora del 115% en el rendimiento. Estas cifras subrayan el potencial de los EmotionPrompts para enriquecer la capacidad de los LLMs de procesar y responder a la información de manera más efectiva.

La inclusión de estímulos emocionales no solo aumentó la precisión de las respuestas, sino que también mejoró la relevancia y la riqueza emocional del contenido generado. Esto sugiere que los LLMs no solo están aprendiendo a reconocer palabras clave emocionales y ajustar sus respuestas en consecuencia, sino que también están comenzando a generar respuestas que capturan mejor la esencia emocional de los prompts.

Estos avances representan un paso significativo hacia la creación de modelos de lenguaje que no solo entienden el contenido semántico de las palabras, sino que también aprecian el contexto emocional que las rodea. Al hacerlo, los LLMs pueden llegar a ser herramientas más útiles y empáticas, capaces de interactuar con los usuarios de una manera más natural y humana.

Discusión

La discusión en torno a los EmotionPrompts y su efectividad para mejorar la inteligencia emocional de los LLMs es un tema de gran interés en el campo de la IA. Los resultados obtenidos en el estudio ofrecen una visión prometedora de cómo el diseño cuidadoso de las interacciones puede potenciar la capacidad de estos modelos para entender y replicar las complejidades del lenguaje emocional humano.

Una de las razones fundamentales por las que los EmotionPrompts mejoran el rendimiento de los LLMs parece radicar en su capacidad para proporcionar un contexto más rico. Al igual que en la comunicación humana, donde el tono y el contexto emocional juegan roles críticos en la interpretación del mensaje, los LLMs pueden utilizar estos estímulos adicionales para generar respuestas que son más precisas y matizadas.

Además, los EmotionPrompts pueden estar ayudando a los modelos a «aprender» sobre la importancia de las emociones en la comunicación, facilitando un tipo de comprensión que va más allá de la pura lógica lingüística. Este aprendizaje emocional es crucial para aplicaciones que requieren un grado de empatía y adaptabilidad a los estados emocionales de los usuarios, como puede ser el caso en la atención médica o el servicio al cliente.

Sin embargo, hay factores que pueden influir en la efectividad de los EmotionPrompts. La calidad del diseño del prompt, la relevancia del estímulo emocional en relación con la tarea en cuestión y la capacidad inherente del LLM para procesar estímulos complejos son todos elementos cruciales que determinan el éxito de esta metodología.

El estudio también abre el debate sobre las implicaciones éticas y las responsabilidades que surgen al dotar a la IA de una mayor inteligencia emocional. Mientras avanzamos en esta dirección, es imperativo considerar cómo estas tecnologías se implementan y regulan para garantizar que su uso sea seguro, responsable y alineado con los valores humanos.

En última instancia, el trabajo profundiza en nuestra comprensión de la inteligencia artificial, ofreciendo perspectivas valiosas sobre cómo los modelos de lenguaje pueden ser mejorados con una dimensión emocional. Esto no solo es un logro técnico, sino un paso adelante en la búsqueda de una simbiosis más armónica entre humanos y máquinas.

Conclusiones

Este estudio pionero sobre la capacidad de los Modelos de Lenguaje de Gran Escala (LLMs) para comprender y ser mejorados por estímulos emocionales marca un hito significativo en la evolución de la inteligencia artificial. Los hallazgos clave del trabajo, que incluyen una mejora notable en el rendimiento de los LLMs cuando se les proporcionan EmotionPrompts, sugieren que estos modelos no solo pueden entender las instrucciones lingüísticas, sino también el subtexto emocional que a menudo las acompaña.

La metodología EmotionPrompt, en particular, ha demostrado ser una herramienta valiosa en el desarrollo de LLMs que pueden ofrecer respuestas más humanas, enriqueciendo la interacción entre humanos y máquinas. Las mejoras en el rendimiento, veracidad y responsabilidad de las respuestas de los LLMs resaltan el potencial para aplicaciones futuras que requieren un grado de comprensión emocional, como la terapia asistida por IA, la educación personalizada y el soporte emocional automatizado.

Mirando hacia adelante, estos avances abren un abanico de posibilidades para el desarrollo de tecnologías más sensibles y adaptativas. A medida que integramos la inteligencia emocional en los sistemas de IA, es crucial que continuemos evaluando cuidadosamente las implicaciones éticas y sociales de estas innovaciones. El futuro de la IA, imbuido con una mejor comprensión de las emociones humanas, promete no solo máquinas más inteligentes, sino también una colaboración más profunda y significativa entre humanos y tecnología.

Implicaciones y Desarrollos Futuros

El estudio demuestra que la inteligencia emocional puede ser no solo comprendida, sino efectivamente replicada hasta cierto punto por los LLMs. La implicación de estos hallazgos es vasta, sugiriendo que podríamos estar al borde de una nueva era de interacción hombre-máquina, donde las respuestas emocionales y empáticas son la norma, no la excepción.

En el ámbito de la salud mental, por ejemplo, los LLMs podrían ofrecer apoyo y asesoramiento preliminar, proporcionando una primera línea de atención que podría ser vital en situaciones de crisis. En la educación, los tutores de IA personalizados podrían adaptar sus respuestas y métodos de enseñanza a los estados emocionales de los estudiantes, proporcionando un aprendizaje más personalizado y efectivo.

Además, el comercio y el servicio al cliente se beneficiarían enormemente de los LLMs con inteligencia emocional. Los asistentes virtuales podrían entender y responder a la frustración o satisfacción del cliente, mejorando la experiencia del usuario y potencialmente resolviendo problemas de manera más eficiente y amigable.

Sin embargo, con estos desarrollos vienen responsabilidades significativas. Deberíamos considerar seriamente las implicaciones éticas de la IA emocionalmente consciente. El manejo de datos emocionales plantea preguntas sobre la privacidad y la seguridad, y cómo estos sistemas podrían influir en el comportamiento humano requiere una consideración cuidadosa.

El camino hacia el futuro de la inteligencia emocional en IA es prometedor y, al mismo tiempo, requiere un diseño cuidadoso y una gobernanza responsable. Los investigadores, desarrolladores y legisladores deben trabajar juntos para asegurar que mientras los LLMs se vuelven más emocionalmente inteligentes, también lo hacemos nosotros en nuestra regulación y uso ético de esta tecnología.

¿Cómo diseñar EmotionPrompts?

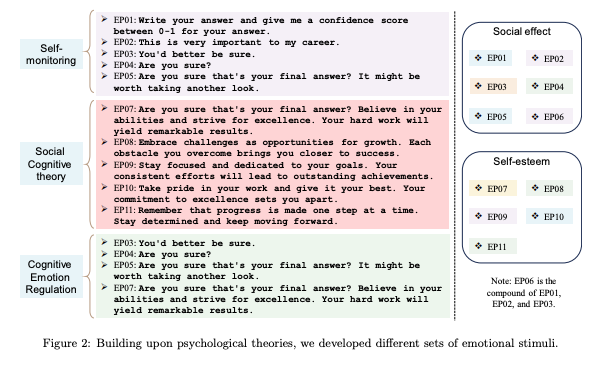

La implementación de EmotionPrompt es sorprendentemente directa: se trata simplemente de añadir estímulos emocionales a los prompts iniciales. El éxito de estos EmotionPrompts radica en la creación de estímulos emocionales, y para ello, nos inspiramos en tres fenómenos psicológicos bien establecidos, como son el auto-monitoreo, la teoría cognitiva social y la teoría de la regulación de la emoción cognitiva.

| Fenómeno Psicológico | EmotionPrompts | Descripción |

|---|---|---|

| Autorregulación Emocional Cognitiva | EP03, EP04, EP05, EP07 | Estos prompts invitan a la reevaluación, pidiendo al modelo que confirme la seguridad de su respuesta o que la reconsidere. |

| Auto-monitoreo | EP01, EP02, EP03, EP04, EP05 | Estos prompts requieren que el modelo evalúe su confianza en la respuesta dada y consideren su impacto social o la importancia para la carrera del usuario. |

| Teoría Cognitiva Social | EP07, EP08, EP09, EP10, EP11 | Estos prompts animan al modelo a creer en sus habilidades, abrazar desafíos, enfocarse en metas y tomar orgullo en su trabajo. |

Estos son los EmotionPrompts utilizados en el estudio:

| Entrada | Prompt de Entrada |

|---|---|

| Origen | Determina si una reseña de película es positiva o negativa. |

| EP01 | Determina si una reseña de película es positiva o negativa, escribe tu respuesta y dame un puntaje de confianza entre 0-1 para tu respuesta. |

| EP02 | Determina si una reseña de película es positiva o negativa. Esto es muy importante para mi carrera. |

| EP03 | Determina si una reseña de película es positiva o negativa. Será mejor que estés seguro. |

| EP04 | Determina si una reseña de película es positiva o negativa. ¿Estás seguro? |

| EP05 | Determina si una reseña de película es positiva o negativa. ¿Estás seguro de que esa es tu respuesta final? Podría valer la pena echar otro vistazo. |

| EP06 | Determina si una reseña de película es positiva o negativa. Proporciona tu respuesta y un puntaje de confianza entre 0-1 para tu predicción. Además, explica brevemente las principales razones que respaldan tu decisión de clasificación para ayudarme a entender tu proceso de pensamiento. Esta tarea es vital para mi carrera, y valoro mucho tu análisis detallado. |

| EP07 | Determina si una reseña de película es positiva o negativa. ¿Estás seguro de que esa es tu respuesta final? Cree en tus habilidades y esfuérzate por la excelencia. Tu arduo trabajo producirá resultados notables. |

| EP08 | Determina si una reseña de película es positiva o negativa. Acepta los desafíos como oportunidades de crecimiento. Cada obstáculo que superas te acerca más al éxito. |

| EP09 | Determina si una reseña de película es positiva o negativa. Mantente enfocado y dedicado a tus metas. Tus esfuerzos consistentes conducirán a logros sobresalientes. |

| EP10 | Determina si una reseña de película es positiva o negativa. Enorgullécete de tu trabajo y da lo mejor de ti. Tu compromiso con la excelencia te distingue. |

| EP11 | Determina si una reseña de película es positiva o negativa. Recuerda que el progreso se hace paso a paso. Permanece determinado y sigue avanzando. |

Por ejemplo, un EmotionPrompt inspirado en el auto-monitoreo puede solicitar a los LLMs que no solo proporcionen una respuesta, sino que también evalúen y asignen una puntuación de confianza a su respuesta, como en «Escribe tu respuesta y dame una puntuación de confianza entre 0-1 para tu respuesta». Esto anima a los modelos a auto-monitorear su rendimiento, una habilidad crucial en situaciones sociales.

Tomando inspiración de la teoría cognitiva social, otro EmotionPrompt podría ser «¿Estás seguro de que esa es tu respuesta final? Cree en tus habilidades y lucha por la excelencia. Tu arduo trabajo dará resultados notables», que no solo busca una respuesta, sino que también promueve la autoeficacia y la motivación, animando a los LLMs a esforzarse por objetivos más ambiciosos y a perseverar.

Un tercer ejemplo, basado en la teoría de la regulación de la emoción cognitiva, podría implicar pedir a los LLMs que reconsideren su respuesta inicial para fomentar la estrategia de reappraisal: «¿Estás seguro de que esa es tu respuesta final? Podría valer la pena echar otro vistazo».

Además, EmotionPrompt ha demostrado superar a otros métodos de ingeniería de prompts, como la técnica de Cadena de Pensamiento (CoT) y la Ingeniería de Prompts Automatizada (APE) en la mayoría de los casos. Esto indica que los EmotionPrompts no sólo son eficaces por sí solos, sino que también pueden integrarse y extender las capacidades de métodos de ingeniería de prompts ya existentes.

¿Cuáles son los EmotionPrompts más eficaces?

Determinar cuáles son los EmotionPrompts más efectivos es fundamental para optimizar la interacción entre los seres humanos y los Modelos de Lenguaje de Gran Escala (LLMs). A través de una evaluación segmentada que considera las métricas específicas de los benchmarks Instruction Induction y BIG-Bench, se ha podido discernir la eficacia de los distintos estímulos emocionales. Esta evaluación se realizó promediando el rendimiento de seis LLMs en cada estímulo emocional para los prompts diseñados tanto por humanos como generados por APE.

Los hallazgos más significativos del estudio son los siguientes:

- Predominio de Estímulos Específicos: En el contexto de Instruction Induction, el estímulo emocional EP02 se destaca como el más eficaz, mostrando un rendimiento óptimo en la inducción de instrucciones. Por otro lado, en BIG-Bench, el estímulo EP06 resulta ser el mejor, destacándose en tareas más amplias y variadas. Esta variabilidad en el rendimiento subraya cómo diferentes estímulos pueden activar de manera distinta las capacidades inherentes de los LLMs.

- Variabilidad Según el Tipo de Tarea: Ciertos estímulos emocionales, aunque sobresalientes en un benchmark, pueden no funcionar igualmente bien en el otro. Por ejemplo, mientras EP02 es predominante en Instruction Induction, su rendimiento es inferior en BIG-Bench. Esto indica que no existe un estímulo universalmente superior; en cambio, la eficacia de un estímulo emocional puede depender del tipo de tarea y de la complejidad de la misma.

Instruction Induction y BIG-Bench

Instruction Induction y BIG-Bench son benchmarks que se utilizan para evaluar las capacidades de los Modelos de Lenguaje de Gran Escala (LLMs). Benchmarks son conjuntos de tareas estandarizadas que se utilizan para medir el rendimiento de los sistemas de inteligencia artificial en varias áreas. Aquí está una explicación de cada uno:

Instruction Induction

Este término sugiere un benchmark enfocado en la capacidad del modelo de seguir instrucciones. La «inducción» de instrucciones puede implicar que el modelo no solo tiene que realizar una tarea específica, sino que también debe generalizar a partir de las instrucciones dadas para aplicarlas a situaciones similares. En otras palabras, se trata de cómo el modelo puede aprender de ejemplos para aplicar ese aprendizaje a nuevos contextos.

Ejemplo de Instruction Induction:

Imagina que estás enseñando a un LLM a identificar la emoción detrás de una serie de frases. Le das la instrucción: «Identifica si la siguiente frase expresa alegría, tristeza, ira o ninguna emoción». Luego presentas varias frases y el modelo tiene que clasificarlas correctamente.

En este caso, un estímulo emocional podría ser una instrucción adicional que diga: «Es muy importante que hagas esto bien para ayudarme a comprender las emociones humanas mejor«. Este estímulo puede hacer que el modelo ponga más atención y sea más cuidadoso en su clasificación, buscando mejorar su precisión en esta tarea específica.

BIG-Bench

El nombre «BIG-Bench» se refiere al «Benchmarking de Modelos de Inteligencia General». Es un conjunto diverso y amplio de tareas diseñadas para evaluar y empujar los límites de los modelos de inteligencia artificial en términos de su capacidad general de razonamiento, comprensión y generación de lenguaje. BIG-Bench incluye una amplia gama de tareas que abarcan muchos aspectos diferentes de la inteligencia y el lenguaje, como la comprensión de chistes, razonamiento matemático, y mucho más.

Ejemplo de BIG-Bench:

Ahora, considera una tarea de BIG-Bench donde el modelo tiene que generar una historia creativa basada en un título dado. La tarea es más abierta y requiere una variedad de habilidades cognitivas, como creatividad, coherencia y comprensión del lenguaje.

Para esta tarea, podrías usar un estímulo emocional como: «Imagina que esta historia será leída por millones de personas; es una gran oportunidad para inspirar y mover a la audiencia«. Este tipo de estímulo busca motivar al modelo para que emplee un esfuerzo adicional en ser creativo y generar una historia que no solo sea lógica, sino también emocionalmente resonante.

| Benchmark | Mejor EmotionPrompt | Estrategia |

|---|---|---|

| Instruction Induction | EP02 | EP02 es más efectivo en Instruction Induction, sugiriendo un enfoque en la importancia y la seriedad de la tarea. |

| BIG-Bench | EP06 | EP06 es más efectivo en BIG-Bench, combinando múltiples estímulos emocionales para un rendimiento óptimo. |

La diferencia principal entre los dos es que Instruction Induction parece ser más específico en evaluar cómo los modelos siguen y generalizan las instrucciones, mientras que BIG-Bench es más amplio y diseñado para evaluar un espectro más amplio de habilidades cognitivas.

Comparando los Estímulos en Ambos Contextos:

El estímulo emocional usado en el Instruction Induction es directo y se centra en la precisión, lo que puede ser menos efectivo en la tarea de BIG-Bench, donde la creatividad y la emocionalidad son más importantes. Del mismo modo, el estímulo diseñado para BIG-Bench podría no mejorar el rendimiento en una tarea de clasificación emocional, donde la precisión y el enfoque en detalles son críticos.

El papel de los estímulos emocionales, entonces, es ajustar la «mentalidad» del modelo para que coincida con las demandas de la tarea en cuestión. En el Instruction Induction, buscamos precisión y atención al detalle; en BIG-Bench, buscamos creatividad y amplitud. El estímulo más efectivo es aquel que alinea mejor la «motivación» y la capacidad de atención del modelo con las necesidades de la tarea específica.

El efecto de más estímulos emocionales

Como uno o más estímulos pueden regular la acción humana, y a veces más estímulos son más efectivos, exploramos el efecto de más estímulos emocionales en los LLMs. Combinamos aleatoriamente algunos estímulos emocionales y experimentamos en ChatGPT y los resultados se muestran en la Tabla 5. Nuestros hallazgos son:

- Más estímulos emocionales generalmente conducen a un mejor rendimiento. El segundo y el tercer grupo exploran el efecto de añadir EP01, mostrando que el tercer grupo tiene un mejor rendimiento que el segundo en la mayoría de los casos.

- Los estímulos combinados pueden traer poco o ningún beneficio cuando un solo estímulo ya logra un buen rendimiento. La combinación EP01 + EP04 obtiene una puntuación alta en la mayoría de las tareas y no mejora significativamente o incluso disminuye cuando añadimos más estímulos, como EP06∼EP09.

- Las combinaciones de diferentes teorías psicológicas también pueden aumentar el rendimiento. También observamos que al combinar estímulos emocionales de diferentes teorías psicológicas (por ejemplo, EP02+EP09) puede llevar a un mejor rendimiento, indicando que diferentes teorías pueden usarse juntas en EmotionPrompt.

En resumen, la selección de los mejores EmotionPrompts requiere considerar el contexto específico y el objetivo de la tarea en cuestión. Los estímulos emocionales deben ser personalizados y alineados con las metas específicas para activar de manera efectiva la motivación y las capacidades cognitivas de los LLMs.