Introducción

En el dinámico mundo de la IA, los avances tecnológicos se suceden a un ritmo vertiginoso, abriendo constantemente nuevas fronteras. Una de estas áreas de rápido desarrollo es la de los Modelos de Lenguaje de Gran Escala (LLMs), que están revolucionando la manera en que las máquinas comprenden y generan lenguaje humano. El reciente estudio «Fine-Tuning or Retrieval? Comparing Knowledge Injection in LLMs«, realizado por Oded Ovadia y su equipo en Microsoft Israel arroja luz sobre dos técnicas cruciales para mejorar la eficacia de estos modelos: el Fine-Tuning y la Generación Aumentada por Recuperación (RAG). Este estudio ofrece una comparativa esclarecedora entre estas dos metodologías.

¿Qué es Fine-Tuning en IA y Por Qué es Importante?

El concepto de Fine-Tuning, o ajuste fino, es fundamental en el mundo de la Inteligencia Artificial. Imagina que tienes un coche de carreras ya potente y eficiente. Sin embargo, para una carrera específica, realizas ajustes en el motor, la suspensión y los neumáticos para adaptarlo a las condiciones únicas de esa carrera. De manera similar, el Fine-Tuning en IA implica tomar un modelo de lenguaje ya entrenado y continuar su entrenamiento con un conjunto de datos más específico y enfocado. Esta técnica es esencial para personalizar los modelos de lenguaje, permitiéndoles desempeñarse mejor en tareas y contextos particulares.

Sin esta personalización, los modelos de lenguaje, por más avanzados que sean, podrían no lograr la máxima efectividad en aplicaciones específicas. Por ejemplo, un modelo entrenado en un amplio espectro de textos generales podría no ser óptimo para entender jergas médicas o términos legales específicos. Aquí es donde el Fine-Tuning se convierte en un jugador clave, adaptando el modelo a las necesidades concretas de un dominio o tarea específica, desde responder preguntas médicas detalladas hasta generar descripciones de productos precisas para el comercio electrónico.

Generación Aumentada por Recuperación (RAG): Un Nuevo Horizonte en IA

Mientras que el Fine-Tuning es como ajustar un coche de carreras para una pista específica, la Generación Aumentada por Recuperación (RAG) podría compararse con equipar ese coche con un GPS avanzado que te permite buscar y encontrar la ruta más eficiente en tiempo real. RAG representa un enfoque novedoso en la inteligencia artificial, donde el modelo de lenguaje no solo se basa en lo que ha aprendido durante su entrenamiento, sino que también busca activamente información adicional de bases de datos externas para enriquecer su respuesta.

Esta capacidad de incorporar conocimientos externos y actuales convierte a RAG en una herramienta poderosa, especialmente en escenarios donde la información está en constante cambio, como noticias de última hora o avances científicos recientes. En tales casos, incluso un modelo de lenguaje bien ajustado puede quedarse atrás si se basa únicamente en su entrenamiento original. RAG, por otro lado, puede buscar la información más reciente, integrarla en su generación de lenguaje y proporcionar respuestas que son no solo precisas, sino también actualizadas.

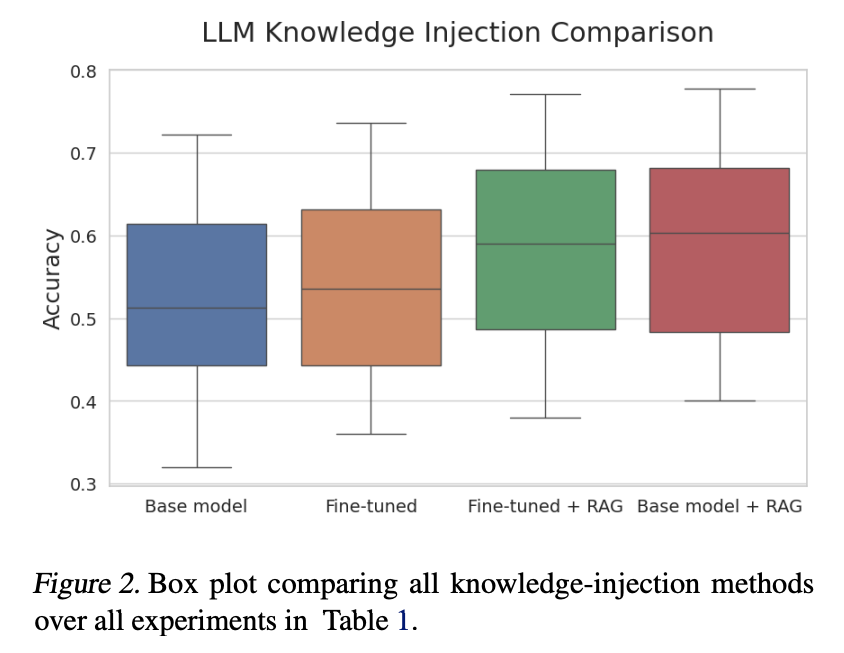

Comparación de Técnicas: Fine-Tuning vs. RAG en Modelos de Lenguaje

El estudio de Ovadia y su equipo en Microsoft Israel aborda una pregunta fundamental: ¿es mejor ajustar un modelo de lenguaje a tareas específicas (Fine-Tuning) o equiparlo para buscar información relevante en tiempo real (RAG)? La respuesta, como en muchos aspectos de la IA, es matizada.

El estudio descubrió que, para tareas que requieren conocimiento especializado o actualizado, RAG supera notablemente al Fine-Tuning. Esto se debe a que RAG puede acceder a información que no estaba disponible durante el entrenamiento original del modelo. Por ejemplo, en tareas relacionadas con eventos actuales o datos específicos de dominio, RAG mostró una capacidad superior para proporcionar respuestas precisas y contextualizadas.

Sin embargo, esto no significa que el Fine-Tuning deba descartarse. Para aplicaciones donde el dominio de conocimiento es estable y bien definido, el Fine-Tuning sigue siendo una técnica valiosa. Permite a los modelos profundizar en áreas específicas, mejorando su precisión en esos dominios.

En resumen, la elección entre Fine-Tuning y RAG depende en gran medida del contexto y de los requisitos específicos de la tarea. Mientras el Fine-Tuning optimiza los modelos para dominios específicos, RAG les permite mantenerse actualizados y relevantes en un mundo donde la información cambia rápidamente.

El Impacto de la IA en el Manejo de Eventos Actuales y Conocimiento Especializado

La habilidad de los LLMs para manejar información sobre eventos actuales y conocimiento especializado es esencial en nuestra era de información rápida y constante evolución. Aquí es donde la Generación Aumentada por Recuperación (RAG) brilla con especial intensidad. Su capacidad para acceder a fuentes de información actualizadas permite a los modelos responder con precisión a preguntas sobre eventos recientes, un área donde el Fine-Tuning, que depende del conocimiento previamente adquirido, puede quedarse corto.

Por otro lado, en dominios donde el conocimiento es más estable y profundo, como ciertas áreas técnicas, científicas o culturales, el Fine-Tuning sigue desempeñando un papel crucial. Al adaptar los modelos a estos dominios específicos, se asegura una comprensión más profunda y matizada del tema.

El estudio de Microsoft Israel destaca la importancia de elegir la estrategia correcta según la naturaleza de la tarea. En un mundo ideal, los modelos combinarían lo mejor de ambos mundos: la profundidad de conocimiento del Fine-Tuning y la capacidad de RAG para incorporar información actual y relevante.

Conclusión

Los avances en técnicas como el Fine-Tuning y la Generación Aumentada por Recuperación (RAG) están marcando un camino emocionante para el futuro de la inteligencia artificial. Mientras que el Fine-Tuning nos permite adaptar modelos de lenguaje a necesidades específicas, RAG abre la posibilidad de mantener estos modelos perpetuamente actualizados y contextualmente relevantes.

El estudio de Oded Ovadia y su equipo es un recordatorio de que en el campo de la IA, no hay una solución única para todos los desafíos. La elección entre Fine-Tuning y RAG, o una combinación de ambos, dependerá de las necesidades específicas de la tarea en cuestión. Este entendimiento no solo mejora nuestra capacidad de desarrollar herramientas de IA más efectivas, sino que también nos acerca a sistemas que pueden entender y responder a nuestro mundo en constante cambio de manera más humana y relevante.

Invitamos a los lectores a mantenerse inquisitivos y curiosos, explorando más sobre estos desarrollos fascinantes en IA. Al mantenernos informados y comprometidos, podemos contribuir a un futuro donde la tecnología y la humanidad se entrelazan de manera armoniosa y constructiva.