AGI: Inteligencia Artificial General

La Inteligencia Artificial General (AGI) es un concepto muy debatido en el campo de la IA, utilizado para describir un sistema de IA que es, al menos, tan capaz como un humano en la mayoría de las tareas.

Dado el rápido avance de los modelos de Aprendizaje Automático (ML), el concepto de AGI ha pasado de ser objeto de debate filosófico a uno con relevancia práctica a corto plazo. Algunos expertos creen que «chispas» de AGI ya están presentes en la última generación de modelos de lenguaje grandes (LLMs); algunos predicen que la IA superará ampliamente a los humanos en aproximadamente una década; algunos incluso afirman que los LLMs actuales son AGIs… Si le preguntaras a 100 expertos en IA qué entienden por «AGI», es probable que obtengas 100 definiciones relacionadas pero diferentes.

Sin embargo, es importante definir qué es la AGI, ya que se trata de un concepto intrínsecamente relacionado con los objetivos, predicciones y riesgos de la IA.

- Objetivos: Alcanzar un nivel de «inteligencia» comparable al humano ha sido una meta implícita o explícita para muchos en el campo de la IA, desde la Conferencia de Dartmouth en 1956 que inició el campo moderno de la IA hasta algunas de las principales empresas de investigación en IA actuales.

- Predicciones: AGI está relacionado con una predicción sobre el progreso en la IA, es decir, hacia una mayor generalidad, acercándose y superando la generalidad humana. Además, AGI suele estar entrelazado con la noción de «propiedades emergentes«, es decir, capacidades no anticipadas explícitamente por el desarrollador. Estas capacidades ofrecen promesas, incluyendo habilidades complementarias a las típicas habilidades humanas, habilitando nuevos tipos de interacción o industrias novedosas.

- Riesgos: Por último, AGI es visto por algunos como un concepto para identificar el punto en el que existen riesgos extremos, como la especulación de que los sistemas AGI podrían ser capaces de engañar y manipular, acumular recursos, avanzar en objetivos, comportarse de manera agentiva, superar a los humanos en amplios dominios, desplazar a los humanos de roles clave y/o mejorar recursivamente.

Hoy diseccionaremos el paper «Levels of AGI: Operationalizing Progress on the Path to AGI«, escrito por Meredith Ringel Morris, Jascha Sohl-dickstein, Noah Fiedel, Tris Warkentin, Allan Dafoe, Aleksandra Faust, Clement Farabet, y Shane Legg de Google DeepMind, donde se propone un marco para clasificar las capacidades y comportamientos de los modelos de Inteligencia General Artificial (AGI) y sus precursores.

El objetivo de este estudio es proporcionar un lenguaje común para comparar modelos, evaluar riesgos y medir el progreso hacia AGI.

- Definir estos conceptos sirve de apoyo para comparaciones entre modelos, evaluaciones de riesgos y estrategias de mitigación, criterios claros para los formuladores de políticas y reguladores, identificación de objetivos, predicciones y riesgos para la investigación y el desarrollo, y la capacidad de comprender y comunicar dónde estamos en el camino hacia AGI.

Definiciones Existentes de AGI

Se han sugerido diferentes propuestas para determinar qué es una AGI; estas son las principales:

- Test de Turing: Un intento bien conocido de operacionalizar un concepto similar a AGI. Propone un juego de imitación para determinar si las máquinas pueden pensar, pero ha sido criticado por destacar más la facilidad de engañar a las personas que la «inteligencia» de la máquina. Sin embargo, la capacidad de pasar el Test de Turing no es suficiente para definir una AGI, ya que es más importante medir lo que la máquina puede hacer en términos de capacidades que si puede «pensar».

- En un post anterior analizamos si GPT-4 puede pasar el Test de Turing.

- AI Fuerte – Sistemas con Consciencia: Propuesta de John Searle que sugiere que una computadora programada adecuadamente es en realidad una mente. Sin embargo, no hay consenso científico sobre cómo determinar si las máquinas poseen atributos de AI fuerte como la consciencia, lo que hace que este enfoque sea poco práctico para definir AGI.

- Analogías con el Cerebro Humano: La definición original de AGI por Mark Gubrud en 1997, que resalta procesos y capacidades, sugiere que la AGI debe rivalizar o superar la complejidad y velocidad del cerebro humano. Sin embargo, el éxito de arquitecturas basadas en transformadores, que no dependen del aprendizaje humano, indica que procesos estrictamente basados en el cerebro no son necesarios para AGI.

- Rendimiento a Nivel Humano en Tareas Cognitivas: Definición de Legg y Goertzel que describe AGI como una máquina capaz de realizar tareas cognitivas que los humanos pueden hacer, enfocándose en tareas no físicas. Esta definición presenta ambigüedades sobre qué tareas y qué personas considerar.

- Capacidad para Aprender Tareas: Propuesta de Shanahan que define la AGI como inteligencia artificial que puede aprender a realizar una amplia gama de tareas como un humano, destacando la inclusión de tareas metacognitivas (aprendizaje) entre los requisitos para lograr AGI.

- Trabajo Económicamente Valioso: La carta de OpenAI define AGI como sistemas altamente autónomos que superan a los humanos en la mayoría de trabajos económicamente valiosos. Esta definición se centra en el rendimiento y no en los mecanismos subyacentes, pero no captura todos los criterios de «inteligencia general».

- Flexible y General – El «Coffee Test» y Desafíos Relacionados: Marcus sugiere que AGI es una inteligencia flexible y general, comparable o superior a la inteligencia humana en cuanto a recursos y confiabilidad. Propone tareas concretas como cocinar en una cocina arbitraria, pero se cuestiona si pasar estas pruebas es suficiente para considerar un sistema como AGI.

- Inteligencia Capaz Artificial: Suleyman propone el concepto de «Inteligencia Capaz Artificial (ACI)» para referirse a sistemas de IA con suficiente rendimiento y generalidad para realizar tareas complejas de múltiples pasos en el mundo real, como aumentar el capital económico significativamente en pocos meses. Esta definición, aunque enfocada en tareas del mundo real, se centra demasiado en la ganancia fiscal.

- LLMs de Última Generación como Generalistas: Agüera y Arcas y Norvig sugieren que los modelos de lenguaje de última generación como GPT-4, Bard y Llama 2 ya son AGIs debido a su generalidad. Argumentan que, dado que los modelos de lenguaje pueden abordar una amplia gama de temas y tareas, han alcanzado suficiente generalidad. Sin embargo, el estudio de DeepMind sostiene que la generalidad debe ir acompañada de un nivel adecuado de rendimiento.

Los Seis Principios para Definir Qué es la AGI

Reflexionando sobre estas nueve formulaciones de ejemplo de AGI (o conceptos adyacentes a AGI), los investigadores de DeepMind han identificado propiedades y características comunes que contribuyen a una definición clara y operacionalizable de AGI, llegando a la conclusión de que cualquier definición de AGI debe cumplir con los siguientes seis criterios:

- Enfocarse en Capacidades, no en Procesos: La mayoría de las definiciones se centran en lo que un AGI puede lograr, no en el mecanismo por el cual realiza las tareas. Esto es importante para identificar características que no son necesariamente un requisito previo para lograr AGI. Este enfoque en las capacidades nos permite excluir de nuestros requisitos para AGI:

- Lograr AGI no implica que los sistemas piensen o entiendan de manera similar a los humanos.

- Lograr AGI no implica que los sistemas posean cualidades como la conciencia (consciencia subjetiva) o la sensibilidad (la capacidad de tener sentimientos).

- Enfocarse en la Generalidad y el Rendimiento: Todas las definiciones anteriores enfatizan la generalidad en diversos grados, pero algunas excluyen criterios de rendimiento. El estudio defiende que, tanto la generalidad como el rendimiento, son componentes clave de la AGI.

- Enfocarse en Tareas Cognitivas y Metacognitivas: Existe debate sobre si requerir la encarnación robótica como criterio para AGI. La mayoría de las definiciones se centran en tareas cognitivas, es decir, tareas no físicas.

- La capacidad de realizar tareas físicas aumenta la generalidad de un sistema, pero no debería considerarse un requisito previo necesario para lograr AGI.

- Por otro lado, las capacidades metacognitivas son requisitos previos clave para que los sistemas logren generalidad.

- Enfocarse en el Potencial, no en la Implementación: Demostrar que un sistema puede realizar un conjunto de tareas requeridas a un nivel de rendimiento dado debería ser suficiente para declarar que el sistema es un AGI; la implementación de tal sistema en el mundo real no debería ser inherente a la definición de AGI.

- Enfocarse en la Validez Ecológica: Las tareas que se pueden usar para evaluar el progreso hacia AGI son críticas para operacionalizar cualquier definición propuesta. Es importante elegir tareas que se alineen con tareas del mundo real (es decir, ecológicamente válidas) que las personas valoren.

- Enfocarse en el Camino hacia AGI, no en un Único Punto Final: Así como la adopción de un conjunto estándar de Niveles de Automatización de la Conducción permitió discusiones claras sobre políticas y progresos relacionados con vehículos autónomos, postulamos que hay valor en definir «Niveles de AGI». Cada nivel de AGI estaría asociado con un conjunto claro de métricas/benchmarks, así como riesgos identificados introducidos en cada nivel y cambios resultantes en el paradigma de Interacción Humano-IA.

Rendimiento y Generalidad en la AGI

Rendimiento y Generalidad: Las dos dimensiones fundamentales para la AGI

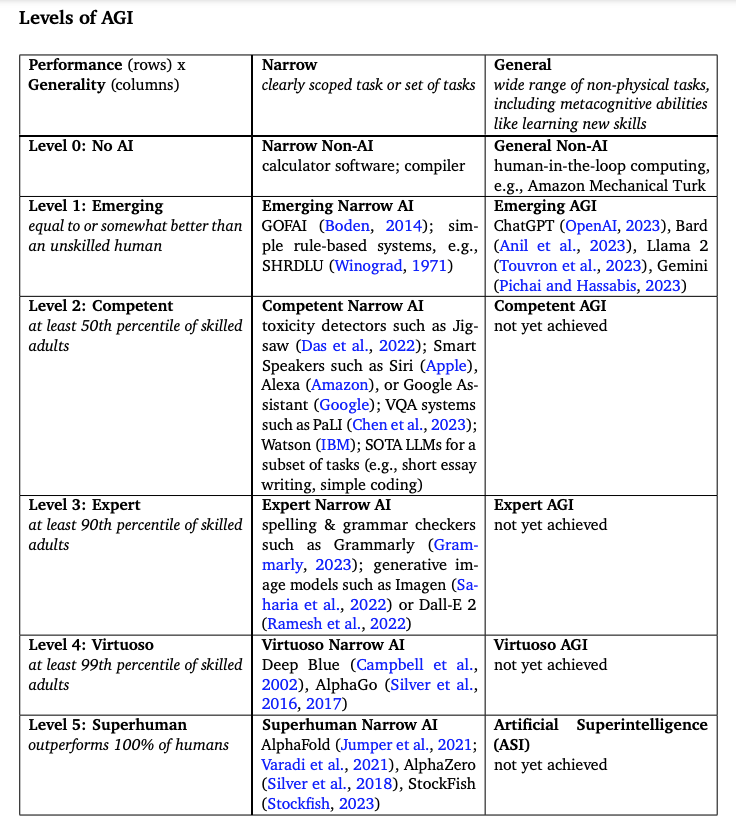

De acuerdo con el Principio 2 («Enfoque en la Generalidad y el Rendimiento») y el Principio 6 («Enfoque en el Camino hacia AGI, no en un Único Punto Final»), en la Tabla 1 se introduce un sistema de niveles matricial que se centra en el rendimiento y la generalidad como las dos dimensiones que son fundamentales para AGI:

- Rendimiento: Se refiere a la profundidad de las capacidades de un sistema de IA, es decir, cómo se compara con el rendimiento a nivel humano para una tarea dada. Para todos los niveles de rendimiento por encima de «Emergente», los percentiles se refieren a una muestra de adultos que poseen la habilidad relevante (por ejemplo, un rendimiento «Competente» o superior en una tarea como la habilidad de escritura en inglés solo se mediría en contra del conjunto de adultos que son alfabetizados y fluidos en inglés).

- Generalidad: Se refiere a la amplitud de las capacidades de un sistema de IA, es decir, el rango de tareas para las cuales un sistema de IA alcanza un umbral de rendimiento objetivo.

Esta taxonomía especifica el rendimiento mínimo en la mayoría de las tareas necesarias para alcanzar una calificación dada.

Por ejemplo, una AGI Competente debe tener un rendimiento de al menos el percentil 50 para adultos humanos calificados en la mayoría de las tareas cognitivas, pero puede tener un rendimiento de Experto, Virtuoso o incluso Sobrehumano en un subconjunto de tareas. Por ejemplo, ChatGPT, Bard o Llama2 exhiben niveles de rendimiento «Competente» para algunas tareas (por ejemplo, escritura de ensayos cortos, codificación simple), pero aún están en niveles de rendimiento «Emergente» para la mayoría de las tareas (por ejemplo, habilidades matemáticas, tareas que involucran factualidad).

Niveles de Rendimiento y Generalidad en la AGI

Según lo anterior, el estudio de Google Deepmind identifica seis niveles de rendimiento y generalidad en la Inteligencia General Artificial (AGI):

- Nivel 0: Sin IA

- Estrecha (Narrow): Software no IA como calculadoras, compiladores.

- General: Computación con humano en el bucle, como Amazon Mechanical Turk.

- Nivel 1: Emergente

- IA Estrecha Emergente: GOFAI (Boden, 2014); sistemas simples basados en reglas, como SHRDLU (Winograd, 1971).

- AGI Emergente: ChatGPT (OpenAI, 2023), Bard (Anil et al., 2023), Llama 2 (Touvron et al., 2023), Gemini (Pichai y Hassabis, 2023).

- Nivel 2: Competente

- IA Estrecha Competente: Detectores de toxicidad como Jigsaw (Das et al., 2022); Altavoces inteligentes como Siri (Apple), Alexa (Amazon), o Google Assistant (Google); sistemas de VQA como PaLI (Chen et al., 2023); Watson (IBM); LLMs SOTA para un subconjunto de tareas.

- AGI Competente: No se ha logrado aún.

- Nivel 3: Experto

- IA Estrecha Experta: Correctores de ortografía y gramática como Grammarly (Grammarly, 2023); modelos generativos de imágenes como Imagen (Saharia et al., 2022) o Dall-E 2 (Ramesh et al., 2022).

- AGI Experta: No se ha logrado aún.

- Nivel 4: Virtuoso

- IA Estrecha Virtuosa: Deep Blue (Campbell et al., 2002), AlphaGo (Silver et al., 2016, 2017).

- AGI Virtuosa: No se ha logrado aún.

- Nivel 5: Superhumano

- IA Estrecha Superhumana: AlphaFold (Jumper et al., 2021; Varadi et al., 2021), AlphaZero (Silver et al., 2018), StockFish (Stockfish, 2023).

- Inteligencia Superartificial (ASI): No se ha logrado aún.

En general, los modelos de lenguaje fronterizos actuales se considerarían un AI General de Nivel 1 («AGI Emergente») hasta que el nivel de rendimiento aumente para un conjunto más amplio de tareas (en cuyo punto se cumplirían los criterios de AI General de Nivel 2 «AGI Competente»).

El orden en el que se adquieren habilidades más fuertes en áreas cognitivas específicas puede tener implicaciones serias para la seguridad de la IA. Por ejemplo, adquirir un conocimiento profundo de la ingeniería química antes de adquirir habilidades sólidas de razonamiento ético puede ser una combinación peligrosa. También se debe tener en cuenta que la tasa de progresión entre niveles de rendimiento y/o generalidad puede ser no lineal. Adquirir la capacidad de aprender nuevas habilidades puede acelerar particularmente el progreso hacia el siguiente nivel.

Mientras que esta taxonomía califica a los sistemas según su rendimiento, los sistemas que son capaces de alcanzar un cierto nivel de rendimiento (por ejemplo, contra un referente específico) pueden no coincidir con este nivel en la práctica cuando se implementan.

- Por ejemplo, las limitaciones de la interfaz de usuario pueden reducir el rendimiento desplegado. Consideremos el ejemplo de DALLE-2, que estimamos como una IA Estrecha de Nivel 3 («IA Estrecha Experta») en nuestra taxonomía.

- Estimamos el nivel «Experto» de rendimiento ya que DALLE-2 produce imágenes de mayor calidad que la mayoría de las personas pueden dibujar; sin embargo, el sistema tiene modos de falla (por ejemplo, dibujar manos con números incorrectos de dígitos, producir texto sin sentido o ilegible) que impiden que alcance una designación de rendimiento «Virtuoso». Aunque teóricamente es un sistema de nivel «Experto», en la práctica el sistema solo puede ser «Competente», porque las interfaces de solicitud son demasiado complejas para que la mayoría de los usuarios finales obtengan un rendimiento óptimo (como lo demuestran estudios de usuarios (Zamfirescu-Pereira et al., 2023) y la existencia de mercados (por ejemplo, PromptBase) en los que ingenieros de prompts capacitados venden instrucciones).

- Esta observación enfatiza la importancia de diseñar referencias válidas ecológicamente (que medirían el rendimiento desplegado en lugar del rendimiento idealizado) así como la importancia de considerar cómo los paradigmas de interacción humano-IA interactúan con la noción de AGI (un tema al que regresamos en la sección «Capacidades vs. Autonomía»).

¿Qué es la ASI?

El nivel más alto en la matriz en términos de rendimiento y generalidad combinados es la ASI («Artificial Super Intelligence»). Es decir, una Super Inteligencia Artificial sería una AGI con un rendimiento «Sobrehumano» superando al 100% de los humanos en una amplia gama de tareas.

- Por ejemplo, el estudio propone que AlphaFold es una IA Estrecha de Nivel 5 («IA Estrecha Sobrehumana») ya que realiza una única tarea (predecir la estructura 3D de una proteína a partir de una secuencia de aminoácidos) por encima del nivel de los mejores científicos del mundo. Esta definición implica que los sistemas de IA General de Nivel 5 («ASI») podrán realizar una amplia gama de tareas a un nivel que ningún humano puede igualar.

Además, este enfoque también implica que los sistemas Sobrehumanos podrían ser capaces de realizar una generalidad de tareas aún más amplia que los niveles inferiores de AGI, ya que la capacidad de ejecutar tareas que difieren cualitativamente de las habilidades humanas existentes superaría por definición a todos los humanos (quienes fundamentalmente no pueden realizar tales tareas).

- Por ejemplo, habilidades no humanas que un ASI podría tener podrían incluir capacidades como interfaces neuronales (quizás a través de mecanismos como analizar señales cerebrales para decodificar pensamientos (Bellier et al. 2023; Tang et al. 2023)), habilidades oraculares (quizás a través de mecanismos como analizar grandes volúmenes de datos para hacer predicciones de alta calidad (Schoenegger y Park 2023)), o la capacidad de comunicarse con animales (quizás por mecanismos como analizar patrones en sus vocalizaciones, ondas cerebrales o lenguaje corporal (Andreas et al. 2022; Goldwasser et al. 2023)).

Cómo Medir y Evaluar el Progreso en AGI

Dos de los seis principios propuestos para definir AGI (Principio 2: Generalidad y Rendimiento; Principio 6: Enfoque en el Camino hacia AGI) influenciaron la elección de una ontología matricial y nivelada para facilitar discusiones matizadas sobre el alcance y la profundidad de las capacidades de la inteligencia artificial (IA).

Los cuatro principios restantes (Principio 1: Capacidades, no Procesos; Principio 3: Tareas Cognitivas y Metacognitivas; Principio 4: Potencial, no Implementación; y Principio 5: Validez Ecológica) se relacionan con el tema de la medición.

Mientras que la dimensión de rendimiento especifica un aspecto de la medición (por ejemplo, rangos percentiles para el rendimiento de tareas en relación con subconjuntos particulares de personas), la dimensión de generalidad deja preguntas importantes abiertas: ¿Cuál es el conjunto de tareas que constituyen los criterios de generalidad? ¿Qué proporción de tales tareas debe dominar un sistema de IA para lograr un nivel dado de generalidad en nuestro esquema? ¿Existen algunas tareas que siempre deben realizarse para cumplir con los criterios para ciertos niveles de generalidad, como tareas metacognitivas?

Operativizar una definición de AGI requiere responder a estas preguntas, así como desarrollar tareas específicas diversas y desafiantes. Debido a la inmensa complejidad de este proceso, así como a la importancia de incluir una amplia gama de perspectivas (incluidos puntos de vista interorganizacionales y multidisciplinarios), el estudio no propone un punto de referencia, sino clarificar la ontología que un punto de referencia debería intentar medir. En el paper también se discute las propiedades que debería poseer un punto de referencia de AGI.

La intención del estudio es definir un punto de referencia para la AGI que incluya una amplia gama de tareas cognitivas y metacognitivas (según el Principio 3), midiendo propiedades diversas que incluyen, pero no se limitan a:

- inteligencia lingüística,

- razonamiento matemático y lógico,

- razonamiento espacial,

- inteligencias sociales interpersonales e intrapersonales,

- la capacidad para aprender nuevas habilidades y

- creatividad.

- Un punto de referencia también podría incluir pruebas que cubran categorías psicométricas propuestas por teorías de inteligencia de la psicología, neurociencia, ciencia cognitiva y educación; sin embargo, estas pruebas «tradicionales» primero deben evaluarse para determinar su idoneidad para evaluar sistemas informáticos, ya que muchas pueden carecer de validez ecológica y de construcción en este contexto (Serapio-García et al., 2023).

Una pregunta abierta para la evaluación del rendimiento es si permitir el uso de herramientas, incluidas las herramientas potencialmente impulsadas por IA, como ayuda para el rendimiento humano. Esta elección puede ser en última instancia dependiente de la tarea y debe tener en cuenta la validez ecológica en la elección del punto de referencia (según el Principio 5). Por ejemplo, al determinar si un automóvil autónomo es suficientemente seguro, compararlo con una persona que conduce sin el beneficio de ninguna herramienta de seguridad asistida por IA moderna no sería la comparación más informativa; dado que el contrafactual relevante implica alguna tecnología de asistencia al conductor, es más apropiado realizar la comparación con esa línea de base.

- Aunque un punto de referencia de AGI podría inspirarse en algunos puntos de referencia de IA existentes (Lynch, 2023) (por ejemplo, HELM (Liang et al., 2023), BIG-bench (Srivastava et al., 2023)), también imaginamos la inclusión de tareas abiertas y/o interactivas que podrían requerir evaluación cualitativa (Bubeck et al., 2023; Papakyriakopoulos et al., 2021; Yang et al., 2023). Sospechamos que estas últimas clases de tareas complejas y abiertas, aunque difíciles de evaluar, tendrán una mejor validez ecológica que las métricas tradicionales de IA, o que las medidas tradicionales adaptadas de la inteligencia humana.

Debido a que es imposible enumerar el conjunto completo de tareas alcanzables por una AGI, un punto de referencia de AGI debería estar en constante evolución. Por lo tanto, dicho punto de referencia debería incluir un marco para generar y acordar nuevas tareas.

Determinar que algo no es una AGI en un nivel dado simplemente requiere identificar varias tareas que las personas típicamente pueden hacer pero que el sistema no puede realizar adecuadamente. Los sistemas que superan la mayoría del punto de referencia de AGI previsto en un nivel de rendimiento particular («Emergente», «Competente», etc.), incluidas las nuevas tareas agregadas por los evaluadores, puede suponerse que tienen el nivel asociado de generalidad para propósitos prácticos (es decir, aunque en teoría aún podría haber una prueba que la AGI no superaría, en algún punto las fallas no investigadas son tan especializadas o atípicas que son prácticamente irrelevantes).

Es decir, este sería el proceso para determinar si un sistema cumple con los criterios para ser considerado como una AGI (Inteligencia Artificial General).

- Identificar tareas que el sistema no puede realizar adecuadamente: Para determinar si un sistema no es una AGI en un nivel dado, se deben encontrar tareas que las personas comúnmente pueden hacer, pero que el sistema no puede realizar satisfactoriamente.

- Superar el punto de referencia de AGI previsto: Si un sistema supera la mayoría de las tareas definidas en un punto de referencia de AGI para un nivel de rendimiento específico, como «Emergente» o «Competente», entonces se puede suponer que tiene el nivel asociado de generalidad para propósitos prácticos.

- Por ejemplo, si un sistema de IA puede realizar eficientemente una amplia gama de tareas cognitivas y metacognitivas, como reconocimiento de voz, resolución de problemas matemáticos y razonamiento abstracto, se podría considerar que alcanza el nivel de AGI «Competente».

- Inclusión de nuevas tareas por los evaluadores: Además de las tareas predefinidas, los evaluadores pueden agregar nuevas tareas al punto de referencia de AGI. Si el sistema puede manejar estas nuevas tareas, esto fortalece la suposición de que tiene el nivel de generalidad asociado.

- Irrelevancia de fallas especializadas o atípicas: Aunque teóricamente podría haber una tarea que la AGI no superaría, en algún punto las fallas no investigadas son tan especializadas o atípicas que se consideran prácticamente irrelevantes.

- Por ejemplo, si un sistema de IA diseñado para traducir idiomas comete errores en la traducción de dialectos raros o poco conocidos, estos errores pueden considerarse irrelevantes en el contexto de evaluar su capacidad general de traducción.

Desarrollar un punto de referencia de AGI será un proceso desafiante e iterativo. No obstante, es un objetivo valioso para la comunidad de investigación en IA. La medición de conceptos complejos puede ser imperfecta, pero el acto de medir nos ayuda a definir claramente nuestros objetivos y proporciona un indicador de progreso.

Riesgo en Contexto: Autonomía e Interacción Humano-IA

Las discusiones sobre AGI a menudo incluyen temas de riesgo, incluyendo el «riesgo existencial» u otros riesgos extremadamente graves. Un enfoque escalonado para definir AGI permite una discusión más matizada sobre cómo diferentes combinaciones de rendimiento y generalidad se relacionan con distintos tipos de riesgo de IA. Aunque es valioso considerar escenarios de riesgo extremo, entender AGI a través de nuestra ontología propuesta, en lugar de como un único punto final (según el Principio 6), puede ayudar a garantizar que los formuladores de políticas también identifiquen y prioricen los riesgos a corto plazo y en el camino hacia AGI.

Niveles de AGI como Marco para la Evaluación de Riesgos

A medida que avanzamos en nuestros niveles de capacidad hacia la Super Inteligencia Artificial, surgen nuevos riesgos, incluyendo riesgos de mal uso, riesgos de alineación y riesgos estructurales. Por ejemplo, el nivel de AGI «Experto» probablemente involucrará riesgos estructurales relacionados con la disrupción económica y el desplazamiento laboral, a medida que más industrias alcancen el umbral de sustitución de la inteligencia artificial en lugar del trabajo humano.

Por otro lado, alcanzar «AGI Experto» probablemente alivie algunos riesgos introducidos por «AGI Emergente» y «AGI Competente», como el riesgo de ejecución incorrecta de tareas.

Los niveles «AGI Virtuoso» y «ASI» son donde es más probable que surjan preocupaciones relacionadas con el riesgo existencial (por ejemplo, una IA que pueda superar a sus operadores humanos en una amplia gama de tareas podría engañarlos para lograr un objetivo mal especificado, como en experimentos de pensamiento de desalineación).

Los riesgos sistémicos como la desestabilización de las relaciones internacionales pueden ser una preocupación si la tasa de progresión entre niveles supera a la regulación o la diplomacia (por ejemplo, la primera nación en lograr ASI podría tener una ventaja geopolítica/militar sustancial, creando complejos riesgos estructurales). En niveles inferiores a «AGI Experto» (por ejemplo, «AGI Emergente», «AGI Competente» y todas las categorías de IA «Específicas»), los riesgos probablemente provengan más de acciones humanas (por ejemplo, riesgos de mal uso de la IA, ya sea accidental, incidental o malicioso).

Un análisis más completo de los perfiles de riesgo asociados con cada nivel es un paso crítico hacia el desarrollo de una taxonomía de AGI que pueda guiar la investigación en seguridad/ética y la formulación de políticas.

Reconocemos que si un punto de referencia de AGI debería incluir pruebas para capacidades potencialmente peligrosas (por ejemplo, la capacidad de engañar, persuadir (Veerabadran et al., 2023) o realizar bioquímica avanzada (Morris, 2023)) es controvertido. Nos inclinamos por incluir tales capacidades en la evaluación comparativa, ya que la mayoría de esas habilidades tienden a tener doble uso (teniendo aplicaciones válidas tanto para escenarios socialmente positivos como nefastos). La evaluación comparativa de capacidades peligrosas se puede reducir al riesgo mediante el Principio 4 (Potencial, no Despliegue) al garantizar que los puntos de referencia para tareas peligrosas o de doble uso estén adecuadamente aislados y no se definan en términos de despliegue. Sin embargo, incluir tales pruebas en un punto de referencia público puede permitir que actores maliciosos optimicen estas habilidades; entender cómo mitigar los riesgos asociados con la evaluación comparativa de habilidades de doble uso sigue siendo un área importante de investigación por expertos en seguridad de la IA, ética de la IA y gobernanza de la IA.

Concurrentemente con este trabajo, Anthropic lanzó la Versión 1.0 de su Política de Escalado Responsable (RSP). Esta política utiliza un enfoque basado en niveles (inspirado en los estándares de nivel de bioseguridad) para definir el nivel de riesgo asociado con un sistema de IA, identificando qué capacidades peligrosas pueden estar asociadas con cada Nivel de Seguridad de IA (ASL) y qué medidas de contención o despliegue se deben tomar en cada nivel. Las IA generativas actuales de SOTA se clasifican como un riesgo ASL-2. Incluir elementos que coincidan con las capacidades de ASL en cualquier punto de referencia de AGI conectaría puntos en nuestra taxonomía de AGI con riesgos y mitigaciones específicos.

Capacidades vs. Autonomía

Mientras que las capacidades proporcionan requisitos previos para los riesgos de IA, los sistemas de IA (incluidos los sistemas AGI) no operan ni operarán en un vacío. Más bien, los sistemas de IA se despliegan con interfaces particulares y se utilizan para lograr tareas específicas en escenarios específicos. Estos atributos contextuales (interfaz, tarea, escenario, usuario final) tienen una influencia sustancial en los perfiles de riesgo. Las capacidades de AGI por sí solas no determinan el destino con respecto al riesgo, pero deben considerarse en combinación con detalles contextuales.

Considere, por ejemplo, las posibilidades de las interfaces de usuario para sistemas AGI. El aumento de capacidades desbloquea nuevos paradigmas de interacción, pero no los determina. Más bien, los diseñadores de sistemas y los usuarios finales se decidirán por un modo de interacción humano-IA que equilibre una variedad de consideraciones, incluida la seguridad.

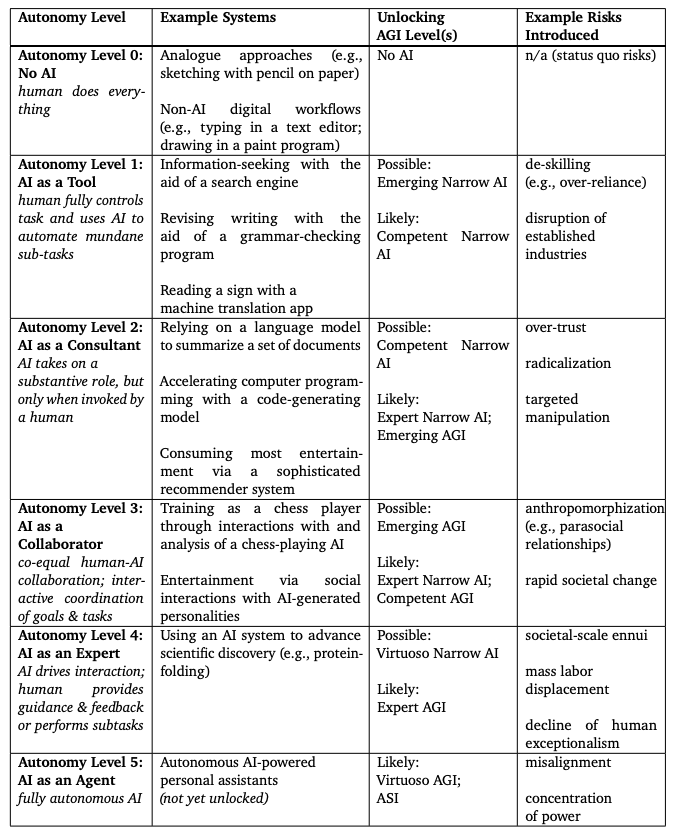

El paper caracteriza los paradigmas de interacción humano-IA con seis Niveles de Autonomía, descritos en la Tabla 2.

La tabla 2 del paper describe diferentes niveles de autonomía en sistemas de Inteligencia Artificial y ejemplos de riesgos asociados:

- Nivel de Autonomía 0: Sin IA – El humano hace todo. Ejemplos incluyen métodos analógicos como dibujar con lápiz en papel, o flujos de trabajo digitales no IA como escribir en un procesador de texto. No se desbloquean niveles de AGI y los riesgos son los actuales (status quo).

- Nivel de Autonomía 1: IA como Herramienta – El humano controla completamente la tarea y usa IA para automatizar sub-tareas mundanas. Ejemplos incluyen buscar información con un motor de búsqueda o revisar la escritura con un programa de corrección gramatical. Puede desbloquear IA Estrecha Emergente o IA Estrecha Competente. Riesgos: deshabilitación (por ejemplo, sobre dependencia), interrupción de industrias establecidas.

- Nivel de Autonomía 2: IA como Consultor – La IA tiene un papel sustancial, pero solo cuando es invocada por un humano. Ejemplos incluyen resumir documentos con un modelo de lenguaje o acelerar la programación con un modelo generador de código. Puede desbloquear IA Estrecha Competente, probablemente IA Estrecha Experta o AGI Emergente. Riesgos: excesiva confianza, radicalización, manipulación dirigida.

- Nivel de Autonomía 3: IA como Colaborador – Colaboración igualitaria humano-IA; coordinación interactiva de objetivos y tareas. Ejemplos incluyen entrenar en ajedrez con una IA o entretenimiento a través de interacciones sociales con personalidades generadas por IA. Puede desbloquear AGI Emergente, probablemente IA Estrecha Experta o AGI Competente. Riesgos: antropomorfización (por ejemplo, relaciones parasociales), cambio social rápido.

- Nivel de Autonomía 4: IA como Experto – La IA dirige la interacción; el humano proporciona orientación, retroalimentación o realiza sub-tareas. Ejemplos incluyen usar un sistema de IA para avanzar en el descubrimiento científico. Puede desbloquear IA Estrecha Virtuosa, probablemente AGI Experta. Riesgos: enajenación social a gran escala, desplazamiento laboral masivo, declive del excepcionalismo humano.

- Nivel de Autonomía 5: IA como Agente – IA completamente autónoma. Ejemplos incluyen asistentes personales autónomos impulsados por IA (aún no se han desbloqueado). Probablemente desbloqueará AGI Virtuosa o ASI. Riesgos: desalineación, concentración de poder.

Estos Niveles de Autonomía están correlacionados con los Niveles de AGI. Niveles más altos de autonomía se «desbloquean» con la progresión de capacidades de AGI, aunque niveles más bajos de autonomía pueden ser deseables para tareas y contextos particulares (incluidas razones de seguridad) incluso mientras alcanzamos niveles más altos de AGI. Elecciones cuidadosamente consideradas en torno a la interacción humano-IA son vitales para un despliegue seguro y responsable de modelos de IA de vanguardia.

- La autonomía en la IA se refiere a la capacidad de un sistema para operar y tomar decisiones independientemente, sin intervención humana directa. Un sistema de IA puede ser altamente autónomo en ciertas tareas o situaciones, pero eso no significa necesariamente que posea las capacidades generales y amplias asociadas con la AGI. De manera similar, un sistema que califique como AGI podría requerir supervisión humana o integrarse en procesos donde las decisiones finales las toma un humano.

- Aunque un sistema de AGI puede tener el potencial para la autonomía, no implica automáticamente que sea autónomo en todas sus operaciones. La AGI se enfoca más en la habilidad y versatilidad cognitiva, mientras que la autonomía se centra en la independencia operativa. Esta distinción es importante para entender los riesgos y desafíos asociados con los sistemas de IA, y subraya la necesidad de una investigación continua en la interacción entre humanos y IA, especialmente a medida que los sistemas de IA se vuelven más capaces

A diferencia de las taxonomías anteriores, que adoptan una perspectiva centrada en la computadora (enmarcando la automatización en términos de cuánto control el diseñador cede a las computadoras), este estudio caracteriza el concepto de autonomía a través del lente de la naturaleza del estilo de interacción humano-IA; además, nuestra ontología considera cómo las capacidades de IA pueden habilitar paradigmas de interacción particulares y cómo la combinación de nivel de autonomía y nivel de AGI puede impactar el riesgo. La automatización no es un juego de suma cero, y que altos niveles de automatización pueden coexistir con altos niveles de control humano; esta visión es compatible con nuestra perspectiva de considerar la automatización a través de la perspectiva de estilos variados de asociaciones humano-IA.

El estudio de google DeepMind destaca la importancia del paradigma «Sin IA». Puede haber muchas situaciones donde esto sea deseable, incluyendo por razones de educación, disfrute, evaluación o seguridad. Por ejemplo, en el dominio de vehículos autónomos, cuando la tecnología de Conducción Autónoma Nivel 5 esté ampliamente disponible, puede haber razones para usar un vehículo Nivel 0 (Sin Automatización). Estos incluyen para instruir a un nuevo conductor (educación), para el placer de los entusiastas de la conducción (disfrute), para exámenes de licencia de conducir (evaluación), o en condiciones donde los sensores no pueden ser confiables como fallas tecnológicas o eventos climáticos extremos (seguridad). Mientras que los vehículos de Conducción Autónoma Nivel 5 (SAE International, 2021) probablemente serían un Nivel 5 IA Estrecha («Superhumana IA Estrecha») bajo nuestra taxonomía, las mismas consideraciones con respecto a la autonomía humana vs. computadora se aplican a AGIs. Podemos desarrollar una AGI, pero elegir no desplegarlo de manera autónoma (o elegir desplegarlo con niveles de autonomía diferenciados en circunstancias distintas según consideraciones contextuales).

Ciertos aspectos de la generalidad pueden ser necesarios para hacer deseables ciertos paradigmas de interacción. Por ejemplo, los Niveles de Autonomía 3, 4 y 5 («Colaborador», «Experto» y «Agente») solo pueden funcionar bien si un sistema de IA también demuestra un fuerte desempeño en ciertas habilidades metacognitivas (aprender cuándo pedir ayuda a un humano, modelado de teoría de la mente, habilidades socioemocionales). Implícito en nuestra definición del Nivel de Autonomía 5 («IA como un Agente») es que tal IA completamente autónoma puede actuar de manera alineada sin supervisión humana continua, pero sabe cuándo consultar a los humanos (Shah et al., 2021). Interfaces que respalden la alineación humano-IA a través de una mejor especificación de tareas, el puenteo de brechas de proceso y la evaluación de resultados (Terry et al., 2023) son un área vital de investigación para garantizar que el campo de interacción humano-computadora se mantenga al día con los desafíos y oportunidades de interactuar con sistemas AGI.

El Paradigma de Interacción Humano-IA como Marco para la Evaluación de Riesgos

La Tabla 2 ilustra la interacción entre el Nivel de AGI, el Nivel de Autonomía y el riesgo. Avances en el rendimiento del modelo y la generalidad desbloquean opciones adicionales de paradigma de interacción (incluida la IA completamente autónoma). Estos paradigmas de interacción, a su vez, introducen nuevas clases de riesgo. La interacción de las capacidades del modelo y el diseño de la interacción permitirá evaluaciones de riesgo más matizadas y decisiones de despliegue responsables que considerar solo las capacidades del modelo.

La Tabla 2 también proporciona ejemplos concretos de cada uno de nuestros seis Niveles de Autonomía propuestos. Para cada nivel de autonomía, indicamos los niveles correspondientes de rendimiento y generalidad que «desbloquean» ese paradigma de interacción (es decir, niveles de AGI en los que es posible o probable que ese paradigma sea desplegado y adoptado con éxito).

Las predicciones de los investigadores de Deepmind con respecto a los niveles de «desbloqueo» tienden a requerir niveles más altos de rendimiento para sistemas de IA Estrecha que para sistemas de IA General; por ejemplo, postulan que el uso de IA como Consultor es probable con una IA Estrecha Experta o un AGI Emergente. Esta discrepancia refleja el hecho de que para sistemas generales, el desarrollo de capacidades probablemente sea desigual; por ejemplo, un AGI de Nivel 1 («AGI Emergente») probablemente tenga un rendimiento de Nivel 2 o incluso Nivel 3 en algún subconjunto de tareas. Tal desigualdad de capacidades para AIs Generales puede desbloquear niveles más altos de autonomía para tareas particulares que estén alineadas con sus fortalezas específicas.

Considerar los sistemas AGI en el contexto de uso por personas nos permite reflexionar sobre la interacción entre avances en modelos y avances en paradigmas de interacción humano-IA. El papel de la investigación de construcción de modelos puede verse como ayudar a que las capacidades de los sistemas avancen en el camino hacia AGI en su rendimiento y generalidad, de modo que las habilidades de un sistema de IA se superpongan a una porción cada vez mayor de las habilidades humanas. Por el contrario, el papel de la investigación de interacción humano-IA puede verse como garantizar que los nuevos sistemas de IA sean utilizables y útiles para las personas de modo que los sistemas de IA extiendan con éxito las capacidades de las personas (es decir, «aumento de inteligencia»)

Conclusión

La Inteligencia General Artificial (AGI) es un concepto con consecuencias tanto aspiracionales como prácticas. En este estudio de Google DeepMind, se analizan nueve definiciones prominentes de AGI, identificando fortalezas y debilidades. Basándonse en este análisis, se formulan seis principios necesarios para una definición clara y operacionalizable de AGI: enfocarse en capacidades, no en procesos; enfocarse en la generalidad y el rendimiento; enfocarse en tareas cognitivas y metacognitivas (en lugar de tareas físicas); enfocarse en el potencial en lugar de la implementación; enfocarse en la validez ecológica para tareas de referencia; y enfocarse en el camino hacia AGI en lugar de un único punto final.

Con estos principios en mente, DeepMind presenta una ontología de Niveles de AGI, que ofrece una forma más matizada de definir nuestro progreso hacia la AGI al considerar la generalidad (ya sea Estrecha o General) en conjunto con cinco niveles de rendimiento (Emergente, Competente, Experto, Virtuoso y Sobrehumano).

En esta investigación también se reflexiona sobre cómo los sistemas de IA actuales y las definiciones de AGI encajan en este marco. Además, se exponen las implicaciones de estos principios para desarrollar un referente de AGI vivo y ecológicamente válido, argumentando que tal esfuerzo (aunque seguramente será desafiante) es vital para que la comunidad se involucre.

Finalmente, el paper considera cómo estos principios y ontología pueden remodelar las discusiones en torno a los riesgos asociados con AGI. Notablemente, se observa que AGI no es necesariamente sinónimo de autonomía. Introduce Niveles de Autonomía que se desbloquean, pero no son determinados, por la progresión a través de los Niveles de AGI. También ilustra cómo considerar conjuntamente el Nivel de AGI con el Nivel de Autonomía puede proporcionar percepciones más matizadas sobre los riesgos probables asociados con los sistemas de IA, subrayando la importancia de invertir en investigación de interacción humano-IA en conjunto con mejoras en el modelo.